El 21 de abril de 2021 se publicó el borrador de un nuevo reglamento de la Comisión Europea relativo al enfoque europeo en materia de inteligencia artificial.

El objetivo de la iniciativa es garantizar que las aplicaciones que recurren a la IA respeten la legislación sobre derechos fundamentales.

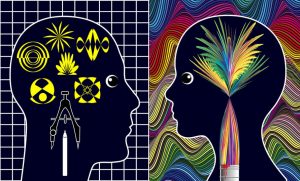

Y es que actualmente sigue existiendo una gran preocupación debido a la complejidad y la opacidad de muchos algoritmos de IA, especialmente en lo que se refiere al llamado problema de la caja negra. A menudo, a los propios usuarios de esta tecnología les resulta imposible conocer los criterios utilizados para tomar una decisión que haya podido desencadenar algún error o prejuicio.

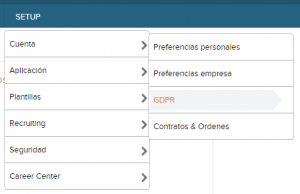

El reglamento sobre IA, al igual que ocurrió con el RGPD, en cuyos procesos se basa en gran medida, supondrá un trabajo adicional tanto para quienes producen esta tecnología, como para las empresas que la importan y distribuyen y las empresas que la han integrado en su negocio.

Está previsto que haya que cumplir ciertos requisitos, so pena de sanciones que podrían ser incluso más importantes que en el caso del RGPD y que pueden alcanzar hasta el 6 % de la facturación anual.

La Comisión Europea prevé que este reglamento —junto con otras iniciativas para la financiación de la IA— sirva también para fomentar un mayor desarrollo de esta tecnología en Europa y conseguir así que el continente compita con Estados Unidos y China.

El marco normativo podría contribuir de dos maneras a una mayor adopción de la IA. Por un lado, el aumento de la confianza incrementará la demanda de estos sistemas en las empresas y las administraciones públicas. Por otro lado, una regulación detallada y común permitirá que los proveedores de IA accedan a mercados más amplios.

Cabe destacar una vez más que se trata del borrador de un reglamento que, sin duda, deberá seguir siendo flexible con el objetivo de regular una tecnología en continua evolución.

No podemos olvidar además que, por el momento, la mayoría de los fabricantes no parece ser capaz de cumplir los criterios establecidos, especialmente en lo relativo a sistemas considerados de alto riesgo, entre los que se encuentran varios algoritmos diseñados para el sector de los Recursos Humanos.

Analicémoslo en detalle.

Los sistemas de IA de alto riesgo y el sector de los RRHH

En el apéndice 3 del reglamento sobre el enfoque europeo para la inteligencia artificial figura el listado de algoritmos considerados de alto riesgo, puesto que las decisiones que toman pueden repercutir en gran medida en la vida de las personas.

Como decíamos, incluye, entre otros, los sistemas de IA diseñados para el sector de los RRHH y, más en concreto:

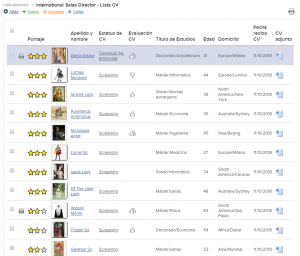

- Sistemas de IA para el reclutamiento y, en particular, para la selección y la clasificación automática de candidatos.

- Sistemas de IA para la gestión de los empleados, que proporcionan sugerencias sobre ascensos y despidos, y evaluaciones de rendimiento.

Todo ello sin olvidar la cuestión de los sistemas biométricos de detección de asistencia. El apéndice 3 habla de los sistemas diseñados para la identificación biométrica de personas en tiempo real y en diferido y no deja claro si dichos sistemas incluyen los que utilizan las empresas para el control de la asistencia y del acceso. Cabe recordar que el RGPD y la autoridad para la protección de datos ya desaconsejan en cierto modo el uso de este tipo de herramientas, que permiten almacenar datos sensibles sin una necesidad real (en la mayoría de los casos basta con la clásica identificación).

También podrían considerarse de alto riesgo los sistemas de IA que determinan los cursos de formación a los que deben apuntarse los empleados.

Las empresas deberán considerar con mucha cautela el uso de estas herramientas de IA para los RRHH, ya que no solo los fabricantes, sino también los usuarios —en el caso de las organizaciones— tendrán que cumplir con los requisitos.

Los sistemas de alto riesgo se consideran dentro de esa categoría si presentan un alto riesgo en cualquiera de los siguientes aspectos:

- Riesgo para la salud

- Riesgo para la seguridad

- Riesgo para los derechos y libertades fundamentales

Por consiguiente, tanto fabricantes como usuarios deberán aplicar una serie de medidas técnicas y organizativas para limitar este riesgo.

En particular, deberán cumplir con los siguientes requisitos.

Gobernanza de datos

Los algoritmos deberán someterse a una serie de análisis durante las fases de entrenamiento, validación y prueba para garantizar que funcionan según lo previsto y de forma segura.

En la fase de entrenamiento será necesario centrarse en la base de datos y en la definición de las características y atributos que determinan el resultado de la aplicación. La base de datos debe ser lo suficientemente grande y pertinente para los fines del sistema, estar completa y no mostrar errores.

Durante la fase de validación hay que prestar atención a los fenómenos de sobreajuste. Si los datos de entrenamiento o las excepciones a la regla estadística cobran demasiada relevancia, el algoritmo acabará por no generalizar lo suficiente.

Por último, durante la fase de pruebas será necesario confirmar que el sistema rinde como se espera.

Un último aspecto clave de esta fase es la puesta a punto del algoritmo. Para garantizar que proporcione respuestas coherentes con los sujetos o con el grupo de sujetos con los que se va a utilizar, habrá que entrenar al algoritmo con datos que tengan en cuenta las características geográficas, de comportamiento y funcionales del contexto en el que se va a aplicar. Los algoritmos entrenados con bases de datos de gran tamaño en EE. UU., por ejemplo, seguramente no se adapten a un uso correcto en España.

Documentación técnica

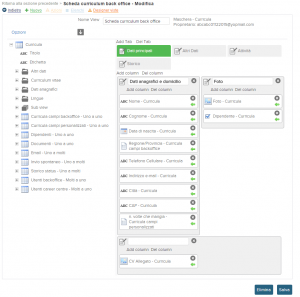

Antes de su comercialización, un sistema de IA debe dotarse de toda la documentación necesaria para demostrar que el sistema en cuestión cumple con la normativa.

Esta documentación, que se actualiza continuamente, debe especificar cómo se ha desarrollado el algoritmo y cuál es su rendimiento durante todo su ciclo de vida.

Sistemas de registro

Las aplicaciones de RRHH que recurren a la inteligencia artificial deberán contar con sistemas que registren los eventos más importantes que se produzcan durante su uso con el objetivo de poder supervisarlas incluso después de su lanzamiento al mercado.

Los sistemas de alto riesgo deberán ser capaces de registrar información como la fecha y la hora de inicio y fin de cada uso y la base de datos con la que se compararon los datos.

Transparencia

Los sistemas de IA de alto riesgo deben diseñarse y desarrollarse teniendo en cuenta la transparencia. Así pues, la lógica con la que toman las decisiones debe ser comprensible para sus usuarios, lo que significa, por ejemplo, que las razones para excluir a un candidato de un proceso de selección deben ser claras y rastreables para cualquiera.

Deben ser igualmente claros los riesgos que el sistema supone para la salud, la seguridad y las libertades fundamentales de los usuarios.

El uso de un lenguaje claro es un tema igual de recurrente que en el RGPD.

Supervisión humana y formación

Los sistemas de IA de alto riesgo deben, desde la fase de diseño, admitir la posibilidad de una intervención humana o, al menos, recurrir a la intervención humana.

En definitiva, tiene que haber siempre un ser humano capaz de controlar su comportamiento.

Es algo que debe hacerse posible gracias a un conjunto de restricciones operativas previstas en el proceso de toma de decisiones del algoritmo y que el sistema no puede ignorar.

Todo ello conlleva la necesidad, tanto para las administraciones como para las empresas, de dotar y formar a su personal con las competencias adecuadas para intervenir en el funcionamiento del sistema de IA cuando este dé error o discrimine o para decidir que su uso no se adapta a las circunstancias.

El reglamento menciona asimismo la posibilidad de utilizar un «botón de parada» o un procedimiento similar para interrumpir el funcionamiento del sistema.

Es probable que se trate de nuevas competencias que deberán formar parte del bagaje técnico del departamento de RRHH en colaboración los informáticos de la empresa.

Precisión, solidez y seguridad informática

Los sistemas de RRHH con IA también deben analizarse en lo que a exactitud, corrección y equidad del resultado algorítmico respecta.

El sistema deberá ser resistente a sus propias limitaciones, errores, fallos, incoherencias y situaciones inesperadas. Tendrá que contar además con soluciones de redundancia, como copias y planes de seguridad para reducir y mitigar los riesgos de dichos daños. Deberá demostrar esa misma resistencia frente a acciones perjudiciales que puedan poner en riesgo la seguridad y provocar comportamientos nocivos.

Todo ello sin olvidar la cuestión de la ciberseguridad y, por lo tanto, de la resistencia a las ciberamenazas. Más en concreto, es necesario prestar atención al envenenamiento de datos, es decir, al riesgo de que los datos, sobre todo en la fase de entrenamiento, estén “contaminados”.

Todo ello para garantizar que los sistemas de alto riesgo generen resultados correctos que no estén distorsionados por amenazas internas o externas.

Conclusiones

El borrador de reglamento, cuya redacción definitiva se espera para los próximos años, arroja un poco de luz sobre las cuestiones éticas y de opacidad que han dominado el debate sobre la inteligencia artificial y han llevado a muchas empresas a dar marcha atrás y deshacerse de estos sistemas a la espera de una tecnología más madura y transparente.

Por ello, de cara al futuro las empresas de la UE deberán prestar atención a la hora de elegir proveedores que cumplan con la normativa y evaluar si conviene utilizar sistemas de IA para los RRHH en casos que no lo requieran estrictamente, exponiéndose así a un riesgo innecesario.

Copyright: ©thodonal/Adobe Stock